Você já se perguntou o que acontece nos bastidores quando conversamos com uma inteligência artificial? Como uma simples pergunta se transforma em respostas tão elaboradas? Por trás da aparente magia tecnológica, existe uma ciência fascinante chamada engenharia de prompts. Este é um campo que está revolucionando a forma como interagimos com sistemas de IA, especialmente para quem assume o papel de gestor destas tecnologias.

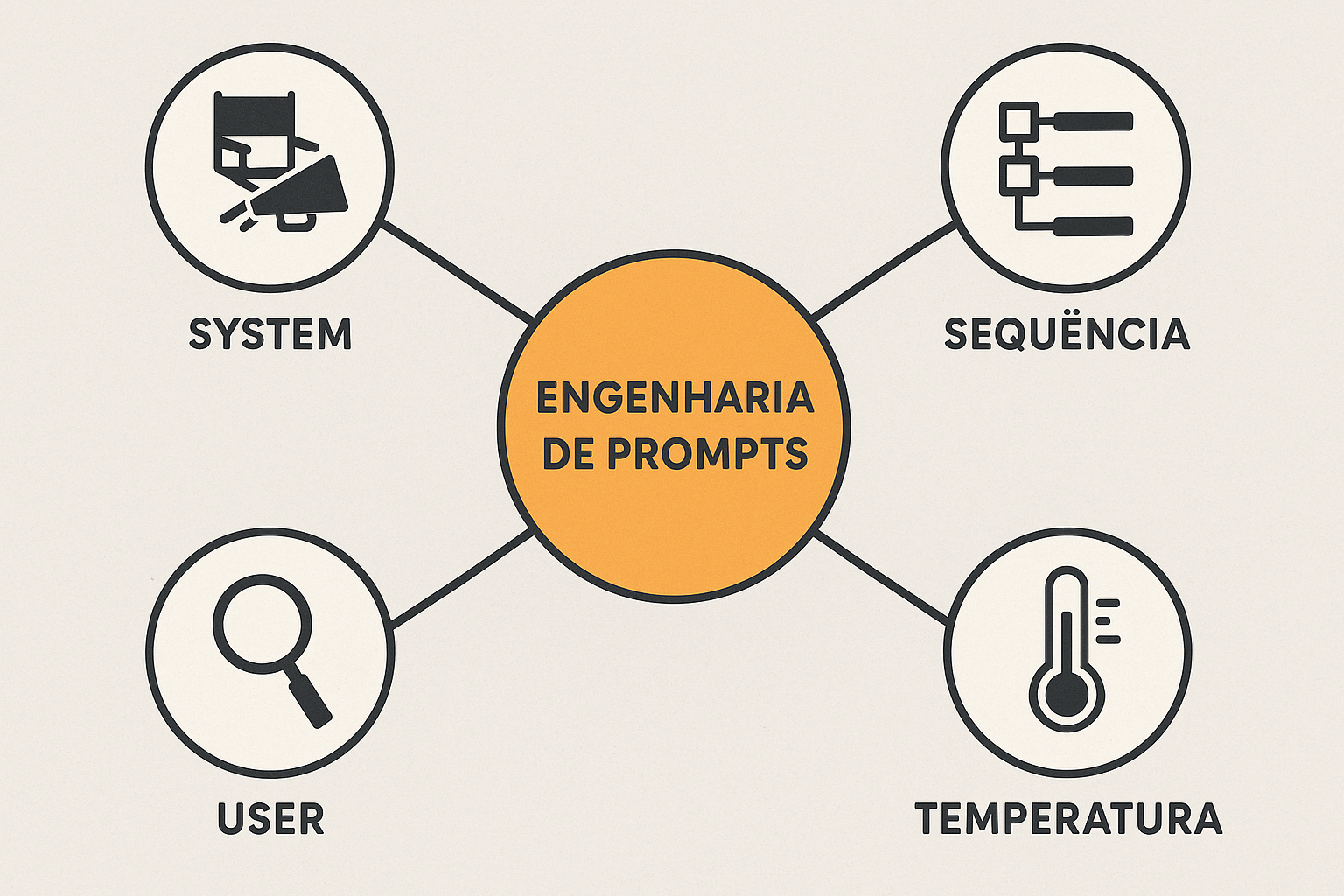

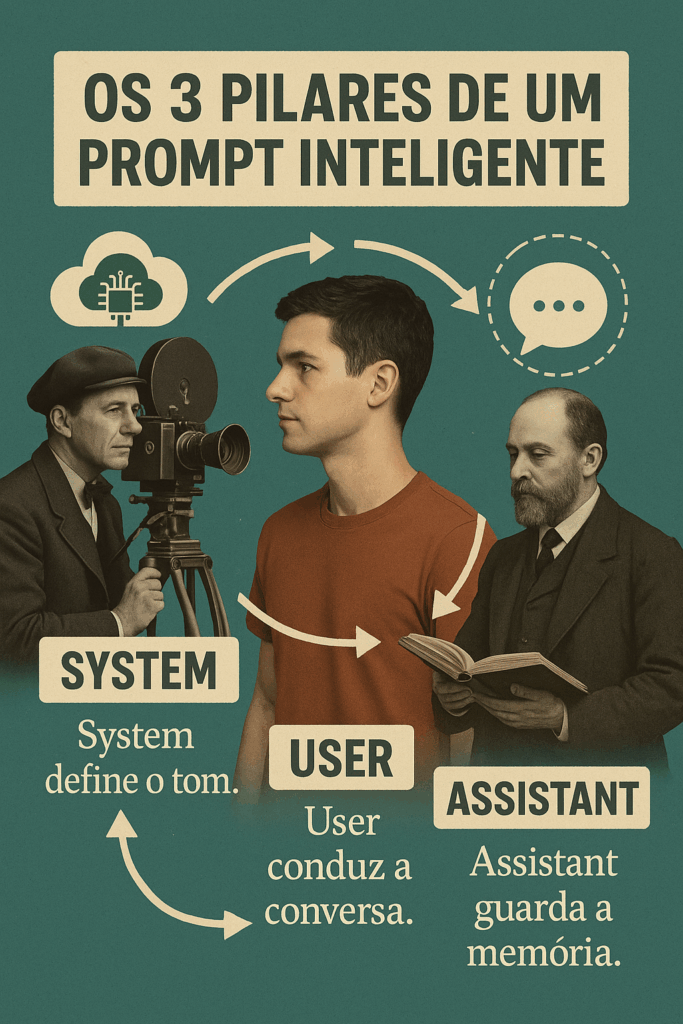

A velocidade com que os modelos de linguagem (LLMs) evoluem é impressionante. O que aprendemos ontem pode ser aprimorado hoje e transformado completamente amanhã. Esta realidade criou uma necessidade urgente de compreender não apenas o que perguntar às IAs, mas como perguntar. Os prompts – estas instruções que fornecemos aos modelos – têm três elementos fundamentais que poucos conhecem em profundidade. O primeiro é o componente “System”, que funciona como um diretor de cinema, definindo o tom, estilo e comportamento que o modelo deve adotar. É fascinante como estas instruções iniciais permanecem como uma memória persistente durante toda a interação. Quando um professor universitário me contou sobre sua primeira experiência configurando o system prompt de um agente virtual para auxiliar seus alunos, ele ficou maravilhado ao perceber como pequenas alterações nas instruções geravam resultados completamente diferentes.

O segundo elemento, o “User”, representa nossas perguntas e instruções imediatas. É o componente mais visível, mas nem por isso menos importante. Ele fornece contexto fresco a cada nova interação, direcionando a conversa para novos territórios. Por último, temos o elemento “Assistant”, que armazena as respostas anteriores e mantém a consistência ao longo da conversa – como um historiador dedicado que nunca esquece o que foi discutido. É curioso notar como cada modelo de IA tem suas próprias preferências quanto à forma de receber estas informações.

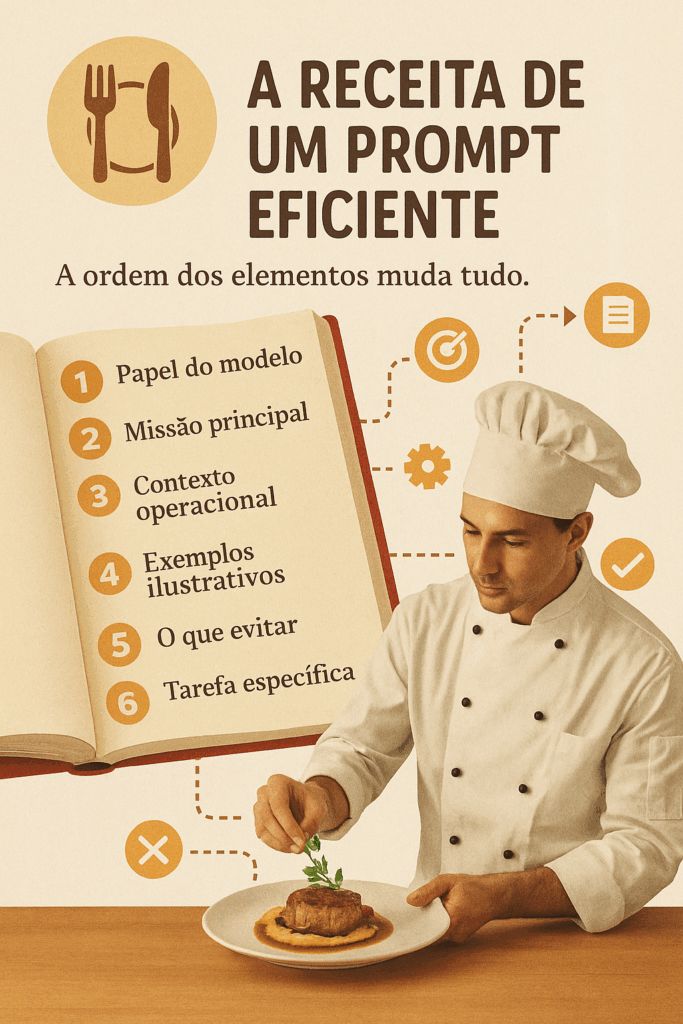

Uma das dúvidas mais comuns entre iniciantes é sobre a ordem ideal dos elementos em um prompt. Não é exagero dizer que a sequência pode fazer toda a diferença no resultado final! A arquitetura básica recomendada começa definindo o papel do modelo, seguida por sua missão principal. Na sequência, vêm o contexto operacional, exemplos ilustrativos, instruções sobre o que evitar e, finalmente, a tarefa específica a ser executada. É como preparar um prato elaborado – a ordem dos ingredientes importa tanto quanto os próprios ingredientes.

A sensibilidade à estrutura varia significativamente entre diferentes modelos. O GPT-4o, por exemplo, dá grande importância aos primeiros tokens do prompt, enquanto o LLaMA 3 é extremamente sensível aos últimos. Esta característica está intrinsecamente ligada à natureza autoregressiva destes sistemas, que geram conteúdo token por token, como um escritor que decide cada palavra após considerar todas as anteriores.

Em 2023, participei de um workshop onde especialistas demonstraram como o mesmo prompt, com os elementos apenas reorganizados, produzia respostas completamente diferentes em diversos modelos. A sala ficou em silêncio absoluto quando viram a transformação – era como presenciar um mágico revelando seus segredos. A chamada “cadeia de pensamentos” (Chain of Thought) é outra técnica fascinante que permite ao modelo “pensar alto”, elaborando respostas mais completas e reduzindo erros de raciocínio.

Um aspecto técnico, mas extremamente relevante, é o controle da “temperatura” nas configurações do modelo. Este parâmetro, que geralmente varia de 0 a 2, atua como o botão de criatividade da IA. Valores próximos de zero produzem respostas mais conservadoras e previsíveis, enquanto configurações mais altas incentivam inovação e originalidade – porém com maior risco de imprecisões. Um professor universitário que conheci utiliza temperaturas baixas para explicações científicas e valores mais altos para sessões de brainstorming com seus alunos.

O mercado já oferece diversas ferramentas para explorar estas técnicas. O ChatGPT possui seus “agentes”, o Gemini trabalha com “gems” (joias) que são agentes personalizados, e o Claude tem suas próprias particularidades. Para questões mais sensíveis, alguns profissionais optam por modelos como o LLaMA ou DeepSheek instalados localmente em seus computadores, garantindo maior privacidade.

Uma reflexão importante que surgiu durante uma conferência recente é que, embora a tecnologia esteja rapidamente se tornando uma commodity, a habilidade de formular perguntas eficientes permanece uma arte valiosa. Como disse um dos palestrantes: “No futuro próximo, não seremos julgados pela tecnologia que usamos, mas pela qualidade das perguntas que fazemos a ela”. Esta perspectiva ressalta a importância da engenharia de prompts como habilidade fundamental para gestores de IA.

A formação de um gestor de IA moderno transcende o conhecimento técnico. Ela incorpora aspectos de psicologia, comunicação e criatividade, transformando o profissional em um verdadeiro intérprete entre humanos e máquinas. À medida que a área se desenvolve, testemunhamos o nascimento de um novo campo profissional especializado, com suas próprias metodologias, boas práticas e certificações.

No final das contas, entender a engenharia de prompts não é apenas dominar uma técnica – é aprender uma nova linguagem. Uma linguagem que nos permite conversar com as inteligências artificiais de forma mais efetiva e produtiva. E como toda linguagem bem aplicada, ela pode abrir portas para possibilidades ainda inexploradas de colaboração entre humanos e máquinas.

Referências: Brown, T.B. et al. (2023). Language Models are Few-Shot Learners. NeurIPS 2023. Anthropic. (2023). Claude: A Conversational AI Assistant. Technical Report. Wei, J. et al. (2024). Chain-of-Thought Prompting Elicits Reasoning in Large Language Models. Nature Machine Intelligence. Google AI. (2024). Gemini: Flexible and Expressive Language Models. Technical Report. Meta AI Research. (2025). Advances in Open Foundation Models. Science, 378(6618).